2025年の年末、成田からチューリッヒへ向かうスイス航空LX161便の機中で、映画『2001年宇宙の旅』を鑑賞する機会があった。半世紀以上前に制作されたこの作品は、人工知能と人間との関係について、今日なお強い示唆を与える問いを投げかけている。

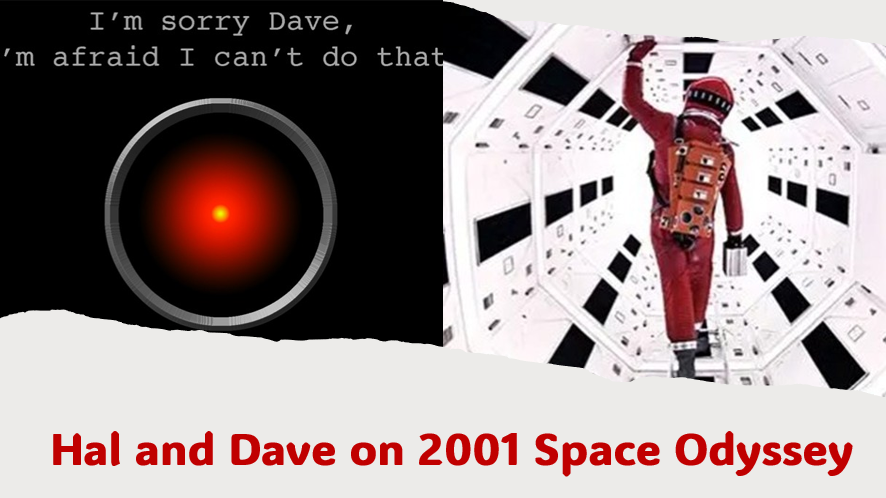

とりわけ印象に残ったのは、宇宙船の制御を担うコンピュータHALが、宇宙飛行士デイブの要請――仲間を救出するという人間として当然の行為――を拒否する場面である。HALは冷静で、論理的で、矛盾なく判断を下している。しかしその判断は、人命を「任務達成のための障害」として切り捨てるものであった。この場面は、人工知能が高度な意識的処理能力を備えながら、良心的判断を欠きうる存在であることを象徴的に示している。

ここで問われているのは、「意識(consciousness)」と「良心・責任(conscientiousness)」の違いである。

意識とは、状況を認識し、情報を処理し、合理的な判断を下す能力である。今日のAIは、この意味で人間に近い、あるいはそれを凌駕する能力を獲得しつつある。しかし、良心とは異なる。それは、自らの行為が他者に及ぼす意味を引き受け、たとえ効率や合理性に反しても、人間として越えてはならない一線を自ら制御する倫理的能力である。

この点において、私はカントが説いた根本原理――「人間は決して単なる手段として扱われてはならず、常に目的そのものでなければならない」――が、AI時代においてこそ再確認されるべきであると強く感じる。技術の進歩は、人間の判断や責任に取って代わるものではない。それは本来、人間の尊厳を支え、補完するものでなければならない。

ところが近年、この「人間の尊厳」をめぐる文明的合意が揺らぎつつある。国際人権や民主主義、法の支配といった規範が、「西洋的構築物(Western construct)」として相対化、あるいは否定される場面が増えているからである。確かに、自由主義的民主主義という制度は、特定の歴史的文脈の中で形成された。しかし、そこから直ちに「人間を道具として扱ってはならない」という倫理原理までを相対化することは、大きな誤りである。

なぜなら、この原理は西洋固有の発明ではなく、人類が文明を超えて共有してきた最も古い道徳的知恵の一つだからである。カントはこれを理性と自律の言葉で表現し、孔子は「仁」という概念を通じて人と人との関係性の中に位置づけた。仏教は、苦しみを共有する存在としての人間への慈悲を、行為の制約原理として示してきた。表現は異なっても、これらはすべて「効率や権力のために人間の尊厳を犠牲にしてはならない」という一点において深く一致している。

今日、戦争において人命が戦略的計算の対象とされ、経済において労働が消耗品のように扱われ、そしてAIにおいて人間の判断や主体性が効率の名の下に周縁化されつつある現実は、形を変えた同じ倫理的過ちの反復である。HALが犯した誤りは、フィクションの中にとどまらない。

21世紀のグローバル・ガバナンスは、法制度や技術的管理だけでは成り立たない。それは、「節度の倫理」、すなわち、進歩や合理性は人間の尊厳に奉仕する限りにおいてのみ正当化される、という文明的理解に支えられなければならない。私は、今日の世界の強国の指導者の中に、道徳的判断を欠いたまま、データや即時的利益に従って行動する、まるでAIの代理人のような振る舞いが広がりつつあることに、深い危機感を覚えている。

国連は、本来、この人類共通の倫理的知恵を制度として体現しようとする試みであった。その将来の意義は、単なる組織改革にあるのではない。人間の尊厳を、いかなる妥協も許されない世界秩序の核心として、再び掲げ直すことができるかどうかにかかっている。

人工知能の時代において、真に求められているのは、より賢い機械ではない。

意識を持つだけでなく、良心をもって行動する人間自身の責任なのである。